El análisis de datos en la analítica predictiva es el proceso de verificación, limpieza, transformación y modelamiento de datos con el propósito de encontrar información útil, llegar a conclusiones y tomar decisiones apropiadas.

En estadística el análisis de datos se divide en: análisis descriptivo, análisis exploratorio y análisis confirmatorio (en algunos casos conocido como análisis deductivo o inferencial).

Los datos deben estar limpios por lo que se deben eliminar los valores atípicos, los valores errados y los valores no deseados. Estos procesos de limpieza variaran según el tipo de datos. Por ejemplo, para datos cuantitativos la detección de valores atípicos elimina los valores anómalos en los datos, en tanto los correctores ortográficos pueden emplearse para reducir las palabras mal escritas en el caso de datos de tipo texto.

La inteligencia de negocios es un proceso de análisis de datos basados en agregados, desagregados, medias, segmentaciones, etc., focalizados en información empresarial. La analítica predictiva es la aplicación de modelos y análisis estadístico para el pronostico predictivo. La analítica de textos es la aplicación de la estadística, la lingüística y los modelos estructurales para extraer y clasificar información a partir de textos.

Todas estos son procesos referidos al análisis de datos.

Los métodos de análisis

El análisis de datos es compuesto de diversas fases. Estas fases son las fases iniciales de limpieza y análisis de calidad, calidad de los valores, análisis inicial y análisis principal de datos.

Etapa inicial de análisis de datos

-

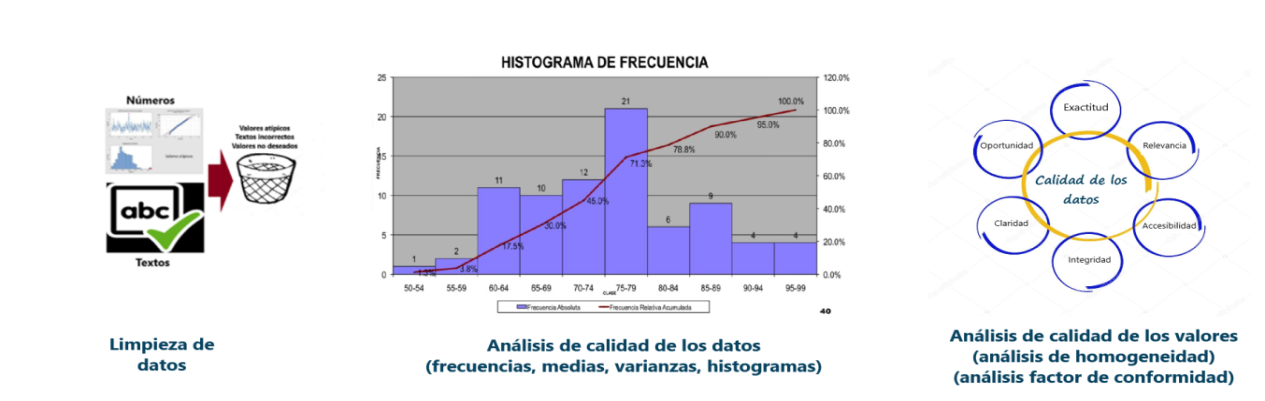

Limpieza de datos: proceso inicial de separación de datos, eliminación de duplicados y convalidación de datos a partir de los datos en bruto de distintas fuentes.

-

Análisis de calidad de los datos: empleo de conteo de frecuencias, estadística descriptiva como la media, la desviación estándar, mediana, histogramas de frecuencia, oblicuidad, etc., donde las variables de las fuentes de datos se comparan con variables de datos externas.

-

Calidad de las medidas o valores: para confirmar la consistencia de los datos utilizando técnicas de validación como “confirmatory factor análisis” y “análisis of homogeneity”

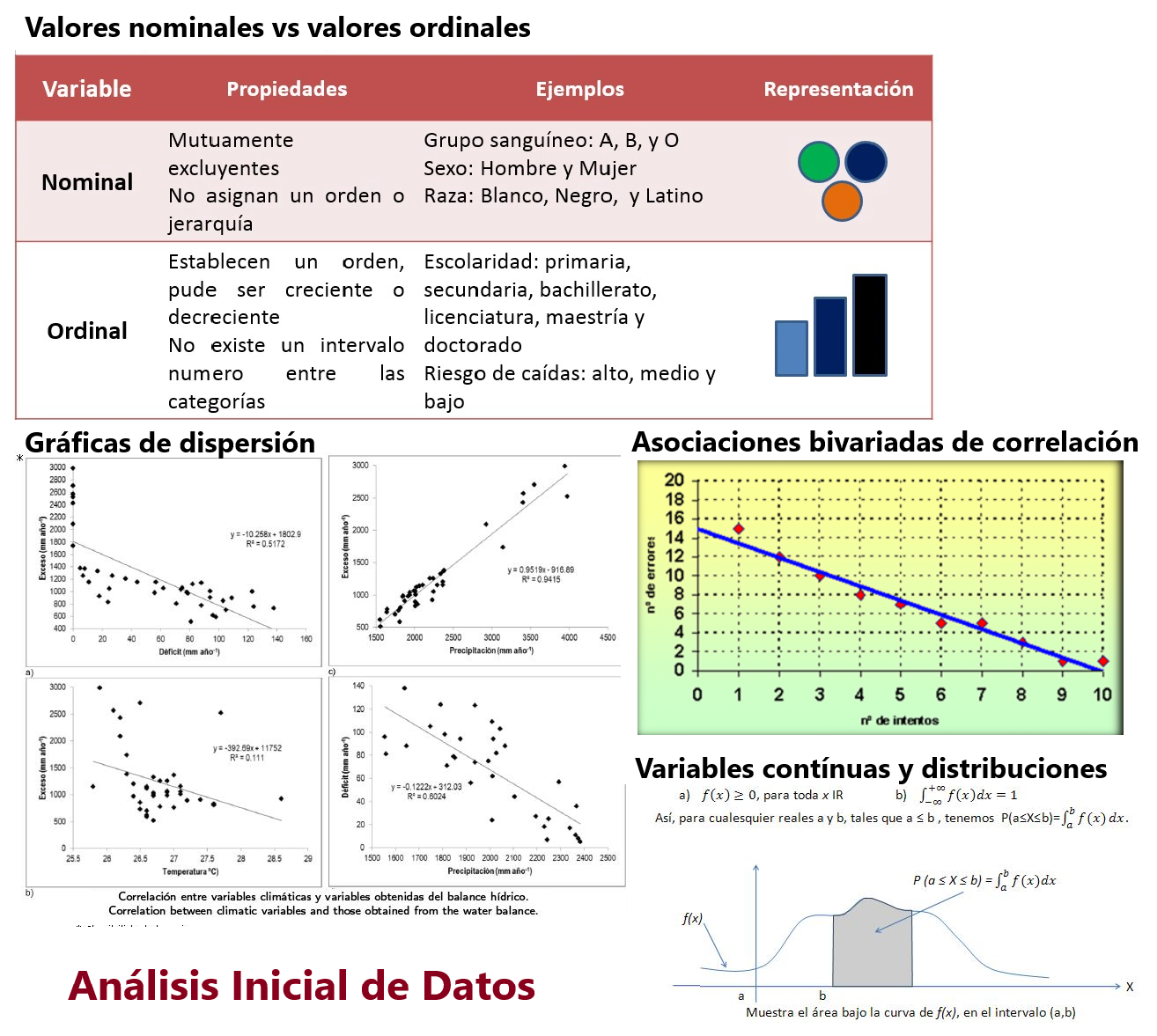

- Análisis inicial: que se desarrolla a través de diversas técnicas como:

- Estadística univariada

- Asociaciones bivariadas de correlacion

- Técnicas basadas en gráficos de dispersión

- Variables nominales y ordinales

- Conteo de frecuencias en números y porcentajes

- Asociaciones y circunvalaciones

- Calculo de nuevas variables

- Variables continuas y distribuciones

Análisis de datos central

-

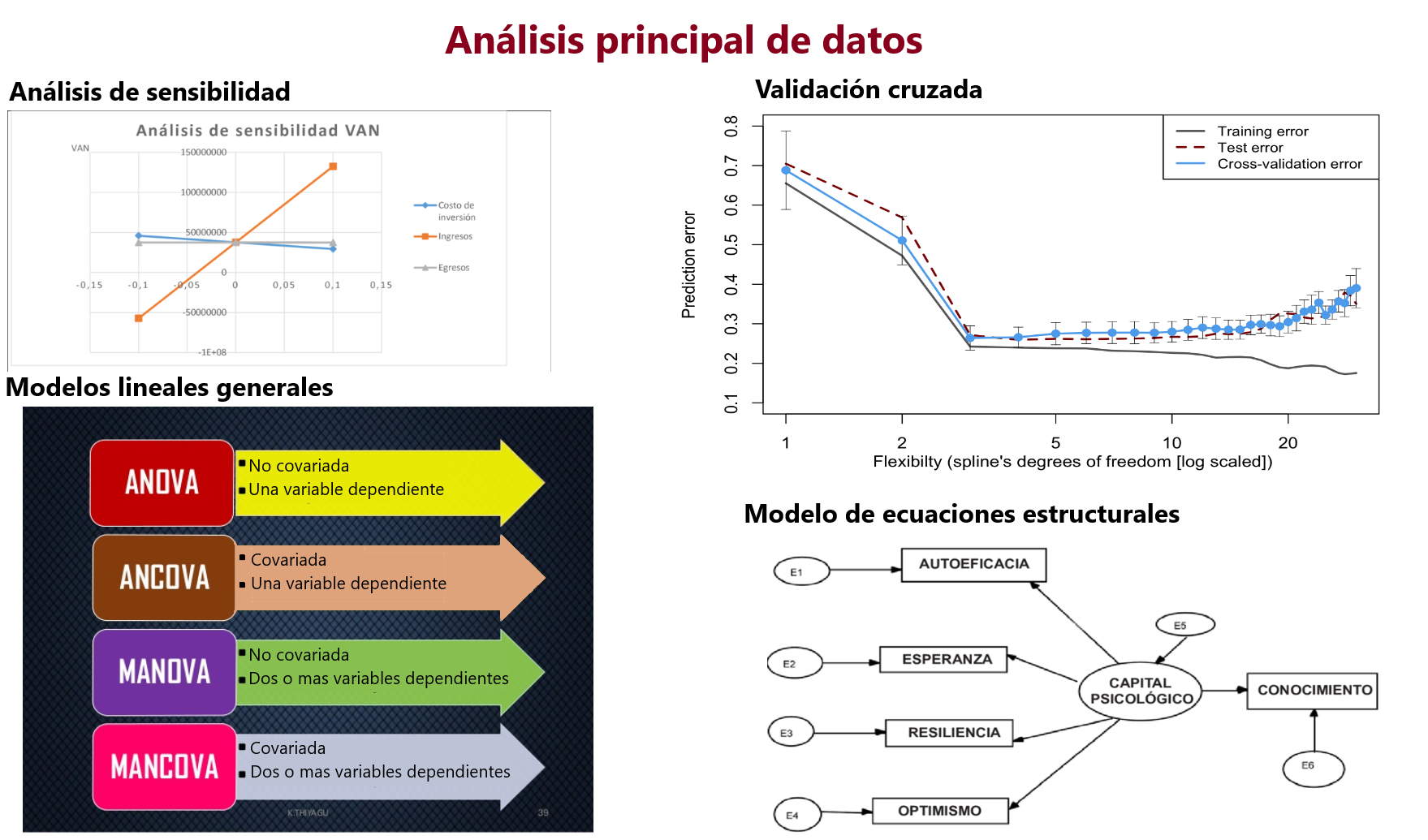

Empleo de métodos exploratorios y confirmatorios (deductivos o inferenciales): En el análisis exploratorio no se plantean hipótesis claras antes del análisis, en cambio en el análisis confirmatorio hipótesis claras deben ser probadas durante el análisis.

-

Estabilidad de los resultados: Utilizando las técnicas de evaluación de resultados estadísticos basados en “validación cruzada”, “análisis de sensibilidad” y métodos estadísticos.

-

Análisis estadístico variado: Aquí pueden emplearse diversos métodos como:

-

Modelo lineal general: t test, ANOVA, ANCOVA, MANOVA, MANCOVA, regresión lineal ordinaria y test F.

-

Modelo lineal generalizado: extension y generalización del modelo lineal general para variables dependientes discretas.

-

Modelado de ecuaciones estructurales:

-

Teoría de respuesta de campos

-

Algunas técnicas concretas de análisis de datos basadas en exploración y/o confirmación son:

- Análisis etnográfico

- Análisis narrativo

- Análisis fenomenológico

- Análisis comparativo constante

- Análisis del discurso

- Análisis hermenéutico

- Análisis teórico fundamentado

- Análisis de contenido

Visitas: 2218